English version available here

Prefazione

Ho sempre avuto una mente curiosa. La curiosità si è sempre palesata sotto forma di voglia di esplorare, di capire, di comparare. Non esiste, a mio avviso, uno strumento adatto ad ogni scopo e i miei scopi sono talmente tanti da suggerirmi continua esplorazione degli strumenti esistenti.

Il mio primo cellulare è stato il Motorola “Timmy” (Motorola 6700), nel 1996. Ad esso sono seguiti vari Nokia, Sony-Ericsson, vari dispositivi Symbian. Poi sono arrivati i BlackBerry e, nel 2009, il mio primo dispositivo Android, un HTC Dream.

Nel 2010 ho iniziato ad avvicinarmi al mondo iPhone e il mio iPhone 4 è stato un eccellente dispositivo, compagno di moltissimi viaggi e moltissime foto. Da quel momento in poi, ho sempre cercato di mantenermi aggiornato su entrambi i fronti (Android/iOS) propendendo per l'uno o per l'altro in base ai periodi e alle necessità. Ho avuto vari device. Nella famiglia dei dispositivi "Google Experience" , gli ultimi due sono stati il Galaxy Nexus e il Nexus 4, acquistati a breve distanza l'uno dall'altro. Il primo, maggior qualità ma fotocamera non all'altezza, il secondo decisamente più apprezzato ma ho avuto presto problemi hardware (tasto di accensione difettoso). Poi mi sono rivolto ad altri produttori (LG G2, Zuk Z1, Samsung Galaxy S7 Edge, Huawei Mate 10 Pro, Xiaomi Mi9T Pro, solo elencando i principali). Ci sono stati anche alcuni Windows Phone, tanto per dimostrare che cerco di avere un approccio sia aperto che critico nei confronti di tutte le soluzioni.

Nel 2020, complice la Pandemia, ho acquistato un iPhone 11 Pro, che mi ha riavvicinato al mondo Apple. Efficiente, funzionante, buona autonomia, stabile e veloce, il dispositivo è stato tra le mie mani per circa un anno e mezzo, fino al Settembre 2021. È stato sostituito da un iPhone 13 Pro Max, mio dispositivo principale. Almeno fino a poche settimane fa.

Dopo aver assistito al Google I/O del 10 Maggio scorso, ho capito che Android stava prendendo una direzione ben definita. E mi sono incuriosito, motivo per cui ho ordinato un Google Pixel 7, da affiancare al mio iPhone.

L'iPhone 13 Pro Max (256 GB)

Acquistato al "day one", è un dispositivo che si è comportato bene sin da subito. Ottima durata di batteria (per me tra le caratteristiche più importanti), ottime fotografie e filmati (importante come per l'autonomia), ecosistema Apple chiuso ma efficiente. Mi ha servito, fino ad oggi, senza particolari sorprese - a parte qualche bug di iOS non strettamente legato al mio dispositivo. Grande (forse troppo) ma, al contempo, comodo per leggere e per usufruire di contenuti multimediali. Un dispositivo, a mio avviso, decisamente riuscito e ancora oggi, dopo quasi due anni, estremamente valido. Abbinato al suo ecosistema (ho anche un Apple Watch 7), una combinazione vincente.

Il Pixel 7

Lo osservo sin dalla sua uscita in quanto i dispositivi di Google stanno diventando, a mio avviso, i veri competitor dei dispositivi Apple. Esperienza pulita, OS minimalista, funzioni esclusive, hardware progettato in casa. Le recensioni sono mediamente positive, ma chi lo odia sembra odiarlo davvero. Un dispositivo polarizzante, incapace di lasciare indifferenti. Con le sue caratteristiche uniche, ricopre una fascia di mercato specifica. Non l'utente "da centro commerciale" ma quello che vuole essere in prima linea con lo sviluppo di Android e vuole Google come diretto fornitore del software.

La "sfida"

Per molti anni ho portato con me due telefoni. Quando viaggiavo molto all'estero, ne avevo addirittura tre: un "dumb phone" per la sim vocale (hey, erano i tardi '00 e primi '10) e due smartphone, uno con sim italiana e l'altro con sim locale. I dual sim, all'epoca, erano solo dei telefoni mediocri e di pessime prestazioni.

Con l'arrivo del mio primo valido dual sim (Zuk Z1), ho ridotto ad un telefono e la cosa, francamente, mi è molto piaciuta.

E' dunque la prima volta che torno a girare con i due telefoni, uno con sim "vita privata" e l'altro con sim "pubblica" (lavoro, ecc.). Entrambe quotidianamente subissate da molte, troppe chiamate spam, entrambe su stesso gestore, una su sim fisica e l'altra su e-sim.

I due smartphone: Schermo e Batteria

Il primo impatto è stato strano. Appena acceso e configurato, il Pixel è diventato un forno. Quasi impossibile tenerlo in mano per il calore. Ammetto di essermi anche preoccupato, ma avevo letto di questa sua tendenza a scaldarsi. Poi si è raffreddato, diventando comunque tiepido di tanto in tanto. Ho poi scoperto esserci un bug dell'ultimo aggiornamento di Android che, nel giro di pochi giorni, è stato sistemato. A quel punto, il telefono è mediamente freddo in wifi, mentre può diventare tiepido quando fuori e in 4g.

Nei primi giorni di utilizzo, la batteria del Pixel 7, pur utilizzandolo normalmente, aveva una durata ridicola. Ho dovuto caricarlo due volte al giorno, con neanche 3 ore di SoT. Avendo inoltre preso un Pixel 7 e non un 7 Pro, ho notato subito la differenza di schermo tra l'iPhone e il Pixel, principalmente sulla dimensione caratteri/schermo e il refresh rate. Poca importanza su quest'ultimo punto (anche se noto dei microlag, ogni tanto, che con l'iPhone mi ero dimenticato), mentre la dimensione caratteri è ancora un punto un po' dolente. Di sera trovo la dimensione di default un pelo piccola (in certe app), ma lo step appena successivo diventa troppo grande per i miei gusti. Manca una dimensione intermedia (ma, essendo Android, sono sicuro ci sia una soluzione).

Nel complesso, lo schermo dell'iPhone 13 Pro Max è superiore, ma andrebbe paragonato al Pixel 7 Pro, non al 7 liscio.

Dopo alcuni giorni, la batteria si è trasformata. Caricandolo al 100% e staccandolo al mattino, arrivo a sera col 50% o poco meno. Autonomia inferiore all'iPhone 13 Pro Max, ma decisamente accettabile. E' un po', come dice Galeazzi, dr. Jekyll e Mr. Hyde: l'utilizzo della rete 4g (non ho provato il 5g, non mi serve) lo fa scaldare e genera un forte consumo di batteria. Credo che il suo modem interno non sia molto efficiente e, di conseguenza, tenda a consumare e diventare tiepido più di quanto sarebbe opportuno.

Ho spento subito l'Always On Display - non mi serve. Avendo ancora l'iPhone e l'Apple Watch con me, non c'era motivo di tenerlo attivo.

I due smartphone: App e Comodità

Ho installato sul Pixel quasi tutte le App che, di solito, utilizzo con Android e iPhone. Una delle funzionalità (gestite automaticamente dall'app Wireguard di iPhone) è quella di attivare automaticamente una VPN verso un mio server ogni volta che sono su 4g o fuori dalle mie reti wifi. Il server in oggetto mi mette in comunicazione con tutte le VPN di lavoro, private e fa da ad-blocker via dns. Su iPhone questo può essere gestito in maniera molto semplice, efficiente e affidabile direttamente dall'app ufficiale Wireguard. Su Android, no. Ho provato a creare delle automazioni con Tasker e Automate, ma non sono molto affidabili. Alla fine ho rispolverato l'ottimo VPN Client Pro (a pagamento, ma a mio avviso un ottimo strumento) e configurato il tutto in pochi minuti.

Il Pixel batte l'iPhone per trasportabilità, ma sono su due diversi segmenti. Per un confronto più diretto avrei dovuto paragonare il Pixel 7 all'iPhone liscio, non al Pro Max. Nel complesso, l'estetica del Pixel mi piace molto e la barra delle fotocamere lo rende diverso dai tanti, troppi smartphone Android tutti uguali.

Le app, in media, sono le stesse. A parte alcune eccezioni, sono molto simili. Su Pixel adoro il fatto che le gesture siano universali: uno swipe vuol dire "indietro" su tutte le app. Su iOS, invece, tornare indietro può essere uno swipe, una freccia in alto, una freccia in basso, ecc. Non c'è un gesto universale e questo, in molti casi, diventa poco intuitivo. La qualità di molte app, invece, continua ad essere superiore su iOS. La controparte Android sembra spesso raffazzonata, un po' incoerente, a volte troppo diversa dal layout di base. Reddit, ad esempio, è la sagra del lag. Chiaramente ci sono migliaia di dispositivi Android diversi, con diversi schermi, UI, risoluzioni, ecc. Gli iPhone sono pochi e ben definiti, quindi creare un'app coerente per iOS è molto più semplice che crearla per TUTTI gli Android in circolazione.

I due smartphone: Uso quotidiano e notifiche

L'esperienza d'uso è piacevole su entrambi i dispositivi anche se iPhone continua a sembrare più "rifinito", pur più basilare nelle personalizzazioni. Sono una persona che si adatta al proprio dispositivo, spesso ho ancora sfondi, font e impostazioni di default. Non ho mai sentito troppo la necessità di ulteriori personalizzazioni del mio iPhone anche perché, di solito, le scelte fatte da Apple hanno senso e criterio.

Il senso di libertà su Pixel è maggiore, le applicazioni hanno accessi più profondi alle impostazioni e alle funzionaltà del dispositivo e possono modificare (anche radicalmente) quasi tutto. Il supporto dell'intelligenza artificiale sull'uso quotidiano diventa, giorno dopo giorno, più evidente. Impara i dettagli sulla carica, su come le app vengono usate, su altre informazioni in merito a come usiamo il nostro smartphone, ecc.

Ad esempio, trovavo la luminosità troppo bassa al buio, troppo alta con luce normale. E' bastata una "correzione" un paio di volte e non ho più dovuto toccare nulla, il Pixel ha imparato a darmi la giusta luce per i miei occhi.

Le notifiche su iPhone sono fulminee e non consumano molta batteria, in quanto vengono "spedite" da Apple e mostrate direttamente, senza particolari interventi locali. Questo crea un effetto sia positivo (consumo energetico inferiore) che negativo (minore funzionalità e libertà di gestione delle stesse da parte dell'app).

Su Pixel, invece, le notifiche vengono "spedite" da Google ma c'è maggiore possibilità di intervento da parte della relativa applicazione, dunque è importante che essa sia ben programmata e ottimizzata. Se essa dovesse avere dei problemi di prestazioni o consumo, l'arrivo di una notifica potrebbe innescare una serie di operazioni in background, impossibili (o quasi) su iOS.

Sulle notifiche, non c'è paragone. Oltre al fatto che sul Pixel ci siano maggiori opzioni legati alle stesse, posso addirittura selezionare alcune conversazioni delle singole app di messaggistica che debbano/possano bypassare le modalità "non disturbare". Su iPhone, ho impostato che Telegram possa suonare anche di notte, anche in modalità sonno, ma TUTTE le conversazioni potranno farlo. Sul Pixel, posso impostare singole conversazioni, dunque ho impostato solo i canali da cui mi arrivano le notifiche di "Server Down" e il problema è risolto.

I due smartphone: l'ecosistema e gli smartwatch

Abituato all'ecosistema Apple, mi sono subito reso conto di quanto fossi ormai abituato ad un utilizzo integrato. Airdrop e la universal clipboard mi sono mancate sin da subito. Ho parzialmente risolto con Airdroid e Kde Connect, anche se non sono proprio la stessa cosa.

Da anni utilizzo anche un Apple Watch. Prima un 5 da 41mm, poi un 7 da 45. Funzionano bene, mi sono abituato e fatico a stare senza. Apple Pay per pagare, le notifiche, la sincronizzazione dei modi d'uso tra iPhone e Watch. Apple Health ha mandato alert quando ha avuto la sensazione che dormissi poco e che le mie pulsazioni notturne fossero troppo alte (anticipando alcuni problemi di salute già in corso, che in quel momento ignoravo) proprio grazie ai sensori sempre attivi sul Watch.

Il Pixel Watch non mi convince, scarsa autonomia e sensazione di prodotto acerbo. Maturerà con le prossime versioni, ma per ora non sono convinto che sia adatto al mio utilizzo.

Ho trovato, a 129 euro, un Galaxy Watch 4 da 40mm e l'ho preso al volo, proprio per provare l'esperienza ad esso legata.

A quel punto, ho deciso di mettere anche la seconda sim sul Pixel e lasciare per qualche giorno a casa sia iPhone che Apple Watch. Tutto bene per il telefono, ma per il Watch...il divario è evidente. Oltre al fatto che il pieno potenziale del Galaxy Watch viene espresso solo avendo un dispositivo Samsung, l'autonomia e alcune funzionalità sono decisamente inferiori. Il volume è basso, la vibrazione un po' incerta e, problema principale, l'autonomia è ridicola. Basta un'attività all'aperto di due ore per prosciugare la batteria. Inadatto dunque al mio utilizzo, lo tengo come "muletto" in quanto effettua comunque buoni tracciamenti sportivi e del sonno. Però in mancanza di sincronizzazione di sveglie e modi d'uso, fatico a poterlo considerare un dispositivo che rimpiazzi l'Apple Watch.

I due smartphone: una settimana senza iPhone e considerazioni sulla fotocamera

La batteria si è comportata abbasta bene. Non ai livelli dell'iPhone 13 Pro Max, ma sufficiente per arrivare agevolmente a fine giornata. Non sono sicuro, però, che possa reggere una giornata davvero stress. Con l'iPhone 13 Pro Max, ho dimenticato il concetto di Powerbank. Col Pixel non sono sicuro sia saggio affrontare giornate critiche senza portare una riserva, ma nella media va abbastanza bene.

La fotocamera, tanto osannata, inizialmente non mi convinceva. La sensazione era che le immagini fossero troppo scure, spesso troppo contrastate e dure. In realtà, col tempo ed esperienza, ho capito che le foto sono eccelse. Sono naturali, a differenza di quelle dell'iPhone che sono belle subito ma meno ricche di dettagli. Escludendo gli strumenti "Pixel only" come gomma magica e similari, anche solo le regolazioni possibili dall'app Foto del Pixel consentono di personalizzare l'immagine e renderla davvero interessante. Non ho ancora provato i video, credo comunque l'iPhone resti superiore.

Sono sparite le chiamate di spam. Il sistema di filtraggio di Google è estremamente efficiente e da 10/15 disturbatori al giorno, sono arrivato a non riceverne per nulla. Un sollievo, senza ombra di dubbio. Spero vivamente che anche Apple intervenga in tal senso.

Dopo alcuni giorni di limitazioni principalmente legate al Galaxy Watch 4, ho deciso di rimettere una delle due Sim (la e-sim) sull'iPhone, principalmente per poter indossare di nuovo l'Apple Watch. E tutto è tornato come prima. Compreso, purtroppo, lo spam.

I due smartphone: "Suddenly..."

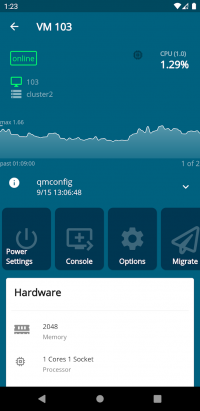

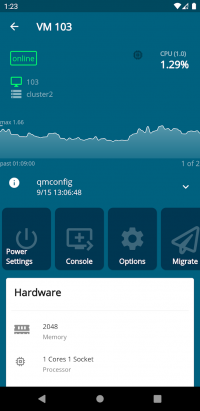

...mi sono reso conto che, pur avendo entrambi i dispositivi a disposizione, cercavo comunque sempre il Pixel. Sono rimasto sorpreso io per primo. Senza dubbio per la maneggevolezza, ma anche per il maggior senso di "libertà" e personalizzazione. Il vero multitasking, utile quando devo fare qualche operazione su server e non voglio che la sessione ssh vada in timeout mentre tiro fuori le password da Bitwarden, così come la possibilità di utilizzare app come quella ufficiale per Proxmox (e non dovermi collegare necessariamente all'interfaccia web mobile di Proxmox, decisamente limitata), e tanto altro.

Su Android, poi, apprezzo il multiutente. Ho sempre avuto un utente test, in cui faccio test e prove di ogni genere, da poter eventualmente cancellare e ricreare. Gli iDevice, invece, nascono per un uso personale.

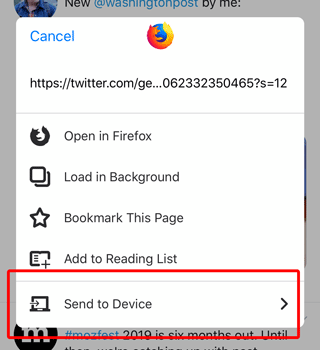

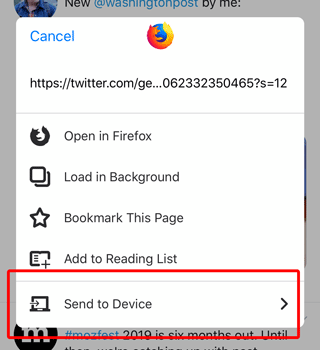

Ultimamente utilizzavo, su tutti i device Apple, il comodo Safari. Ho sempre però avuto problemi con la sincronizzazione delle schede (forte ritardo nella migliore delle ipotesi, giorni o settimane di blocco in altri casi) mentre su Firefox ho sempre apprezzato la possibilità di inviare una scheda ad un dispositivo.

Sul Pixel, ho impostato Firefox come browser predefinito e lo uso davvero, non come su iPhone (ovvero un Firefox con webkit sotto). Adoro la possibilità di inviare una scheda ad un altro device, cosa che faccio spesso da Pixel a Mac quando vedo qualcosa che voglio leggere con calma su computer, quando andrò al computer stesso. Su Safari utilizzo l'Elenco lettura, ma non è proprio la stessa cosa.

I due smartphone: Conclusioni

iOS e Android sono maturati molto, negli ultimi anni. Ad ogni nuova release, l'uno aggiunge funzionalità che l'altro ha già da tempo e viceversa. Non posso dire, dunque, di ritenere l'uno superiore all'altro. Entrambi hanno i propri pro e contro.

iOS presenta un'esperienza pulita, consistente col proprio ecosistema ed estremamente integrata. Le operazioni e modalità possibili sono limitate ma sufficienti e chiare per buona parte dell'utenza. Le ultime release hanno mostrato bug abbastanza importanti e una durata batteria ridotta su molti dispositivi. L'ecosistema è ben fatto, ma uscirne può diventare problematico. Non tutto può essere esportato e una volta dentro diventa difficile uscire. E' questa la ragione per cui le mie foto, oltre che sull'iCloud, sono anche (e principalmente) sul mio Nextcloud privato. Calendari e contatti sono legati alla mia casella di posta (anche se l'iPhone memorizza, in automatico, tutto nella sua rubrica contatti - cosa che non sono ancora riuscito a modificare). Una volta dentro sei dentro e non ci sono le app Apple per Android.

Android su Pixel, essendo la piattaforma di riferimento di Google, offre anch'esso un'esperienza pulita, con caratteristiche univoche e punti di forza non indifferenti come libertà, personalizzazione e un generale senso di apertura. Pur essendo un dispositivo di fascia media, l'esperienza d'uso è decisamente di alto livello e le prestazioni sono notevoli. Non per i benchmark, sia chiaro, ma lasciano il tempo che trovano. Così come per i bug - presenti su Pixel. La sensazione, a volte, è di essere perennemente in "beta".

Le app di Google sono disponibili sia su Android che su iOS (anzi, spesso sono fatte meglio su iOS, il che può sembrare paradossale ma, pensandoci bene, non lo è) e consentono un facile passaggio da una piattaforma all'altra. Le funzionalità tipiche dei Pixel e la libertà d'uso che Android fornisce rendono il Pixel 7 un dispositivo davvero interessante, accendendo ancora di più la mia curiosità verso il Pixel 8, magari stavolta Pro.

Dovessi acquistare un nuovo dispositivo oggi, quale dei due acquisterei? Sarei molto incerto, probabilmente propenderei per un Pixel 7 (Pro), a cui però dovrei poi abbinare un adeguato smartwatch che, ad oggi, non ho ancora identificato. Non che l'iPhone sia inferiore - non lo è, sotto molti aspetti - ma la libertà d'uso del Pixel mi ha restituito una boccata d'aria, persa in questi anni. Probabilmente continuerò ad utilizzarli entrambi, o insieme o alternandoli, in attesa di vedere le novità che usciranno a fine anno.

Photo by Tyler Lastovich on Unsplash

Photo by Tyler Lastovich on Unsplash